英伟达H100启用TensorRT-LLM:AI推理性能飙升

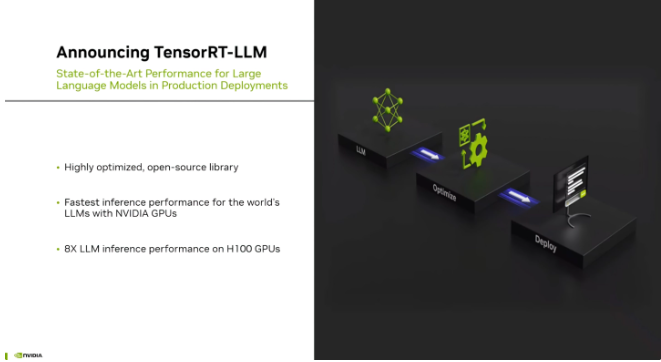

【本站】9月9日消息,英伟达公司今日宣布推出了一项名为TensorRT-LLM的创新项目,旨在大幅提升其Hopper系列AI GPU上的语言模型推理性能。根据英伟达的介绍,TensorRT-LLM是一款深度优化的开源库,利用了一系列尖端技术,包括SmoothQuant、FlashAttention和fMHA等,以加速处理大型语言模型,如GPT-3(175 B)、Llama Falcom(180 B)和Bloom等模型。

据悉,TensorRT-LLM的一个显著特点是引入了一种名为In-Flight Batching的调度方案,这使得GPU能够在处理大型计算密集型请求时,同时动态处理多个较小的查询。这一创新性的方案不仅提高了GPU的性能,还使得H100型号的吞吐量提高了2倍。

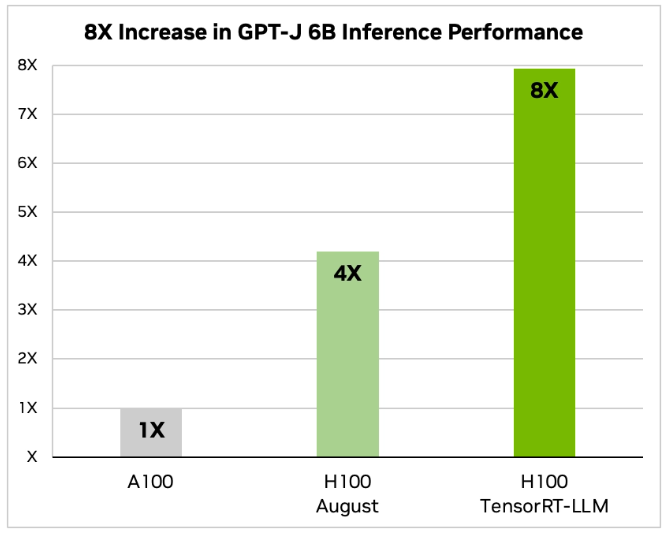

在性能测试方面,英伟达以A100作为基准,对比了H100和启用了TensorRT-LLM的H100。在GPT-J 6B模型的推理性能测试中,H100相比A100提升了4倍,而启用了TensorRT-LLM的H100性能更是达到了A100的8倍。而在Llama 2模型上,H100相比A100提升了2.6倍,而启用了TensorRT-LLM的H100性能则高达A100的4.6倍。

这一重大突破意味着英伟达将继续领导AI硬件领域的发展,通过优化其GPU性能,为大型语言模型等计算密集型任务提供更快速和高效的计算支持。据本站了解,这将对人工智能应用在各个领域的发展产生积极影响,为未来的科技创新打开更广阔的可能性。

相关文章

- 哈弗官方宣布枭龙MAX OTA升级 解决电池保电难题

- 金融大模型发展论坛聚焦马上消金,探讨人工智能与算力建设

- OpenAI首次亮相:11月6日开发者大会即将来袭

- 思想碰撞,脑力激荡 ——“AIGC构建数字世界”第4期人工智能创新技术讲习班成功举办

- 百度云智大会聚焦AI原生应用:李彦宏强调解决问题才是关键

- 360智脑:中国首个通过认证的可信大模型评测

- 三星电子注册“Samsung Gauss”商标,即将推出生成式人工智能平台

- 百度输入法11.7.19.9版本更新:新增“超会写”AI创作助手

- 腾讯2023全球数字生态大会即将发布混元大模型,引发关注

- AI工具FACET评测Meta与OpenAI模型,揭示性别与肤色差异

- 创新合作!同方知网与华为云联合开发面向知识服务的“华知大模型”

- 微软发布Turing Bletchley v3视觉语言模型:图像搜索迎来新突破

- 微软推出Windows 11新功能:人工智能助手Windows Copilot

- 英伟达计划翻倍增产H100人工智能处理器,预计出货量飙升

- OpenAI与Scale AI深度合作,共同增强大语言模型

- 数学领域创新!好未来自主研发MathGPT模型正式面向用户公测

热门教程

Win11每次开机会检查tpm吗?Win11每次开机是否会检查tpm详情介绍

2系统之家装机大师怎么用?系统之家装机大师使用教程

3Win11正式版怎么安装安卓APK应用?Win11安装安卓APK文件方法

4Win10 21H1更新KB5003637后任务栏不能在底部显示怎么办?

5Win11电脑下载的文件被自动删除怎么办?

6Win11资源管理器的样式如何切换?Win11资源管理器样式切换方法

7Win11蓝屏怎么修复?win11蓝屏修复教程

8老电脑怎么装win11系统?老电脑一键升级Win11系统教程

9Win11正式版如何固定“此电脑”到任务栏?

10Win10和Win11哪个好用?Win10和Win11区别介绍

装机必备 更多+

重装教程

大家都在看

电脑教程专题 更多+